nylig NVIDIA ga ut kildekoden for StyleGAN3, et maskinlæringssystem basert på generative negative nevrale nettverk (GAN) for å syntetisere realistiske bilder av menneskelige ansikter.

I StyleGAN3 er tilgjengelig for nedlasting av ferdig opplærte modeller som er opplært i samlingen Flickr-Faces-HQ (FFHQ), som inkluderer 70 tusen PNG-bilder av høy kvalitet av menneskelige ansikter (1024 × 1024). I tillegg er det modeller som er bygget på grunnlag av AFHQv2 (fotografier av dyrs ansikter) og Metfaces (bilder av folks ansikter fra klassiske maleriportretter) samlinger.

Om StyleGAN3

utforming fokuserer på ansikter, men systemet kan trenes til å generere alle typer objekter, som landskap og biler. Hva mer, verktøy er gitt for selvlæring av det nevrale nettverket ved å bruke dine egne bildesamlinger. Krever ett eller flere NVIDIA -grafikkort (Tesla V100 eller A100 GPUer anbefales), minst 12 GB RAM, PyTorch 1.9 og CUDA 11.1+ Toolkit. For å bestemme den kunstige naturen til de mottatte ansiktene, utvikles en spesiell detektor.

Systemet gjør det mulig å syntetisere et bilde av et nytt ansikt basert på interpolasjonen av funksjonene til flere ansikter, som kombinerer deres iboende egenskaper, i tillegg til å tilpasse det endelige bildet til ønsket alder, kjønn, hårlengde, smilkarakter, neseform, hudfarge, briller, fotografisk vinkel.

Generator behandler bildet som en samling stiler, skiller automatisk de karakteristiske detaljene (fregner, hår, briller) av de generelle attributtene på høyt nivå (holdning, kjønn, aldersrelaterte endringer) og lar dem vilkårlig kombineres med definisjonen av dominerende egenskaper gjennom vektingsfaktorer, og at det som et resultat genereres bilder som de kan tilsynelatende ikke skilles fra faktiske fotografier.

Den første versjonen av StyleGAN -teknologi (utgitt i 2019), etterfulgt av en forbedret versjon av StyleGAN2 i 2020, som forbedrer bildekvaliteten og fjerner noen artefakter. Samtidig forble systemet statisk, det vil si at det ikke tillot realistiske animasjoner eller ansiktsbevegelser. Ved utvikling av StyleGAN3 var hovedmålet å tilpasse teknologien for bruk i animasjon og video.

StyleGAN3 bruker en redesignet ikke-aliasing avbildningsarkitekturay tilbyr nye opplæringsscenarier for nevrale nettverk og inkluderer også nye verktøy for interaktiv visualisering (visualizer.py), analyse (avg_spectra.py) og videogenerering (gen_video.py). Implementeringen reduserer også minneforbruket og fremskynder læringsprosessen.

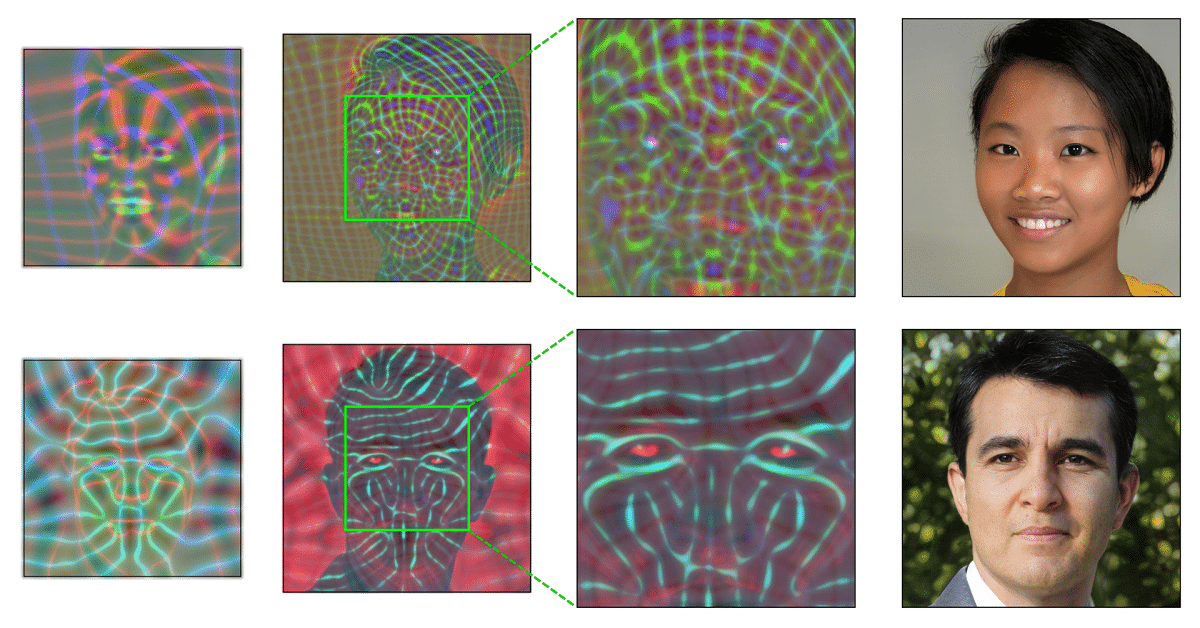

Et sentralt trekk ved StyleGAN3 -arkitekturen var overgangen til tolkningen av alle signaler i det nevrale nettverket i form av kontinuerlige prosesser, som gjorde det mulig å manipulere relative posisjoner ved å danne deler, ikke knyttet til de absolutte koordinatene til individuelle piksler i bildet, men festet til overflaten av de representerte objektene.

Mens i StyleGAN og StyleGAN2 forårsaket problemer med dynamisk gjengivelse å snappe til piksler under byggingenFor eksempel, når bildet var i bevegelse, var det en mismatch av små detaljer, for eksempel rynker og hår, som så ut til å bevege seg separat fra resten av ansiktsbildet, i tillegg til at i StyleGAN3 er disse problemene løst og teknologien har blitt ganske egnet for videogenerering.

Endelig, også verdt å nevne kunngjøringen av opprettelsen av NVIDIA og Microsoft av den største MT-NLG-språkmodellen basert på et dypt nevrale nettverk med en «transformativ» arkitektur.

Modellen dekker 530 milliarder parametere og et basseng på 4480 GPUer ble brukt for trening (560 DGX A100 -servere med 8 A100 GPUer på 80 GB hver). Bruksområdene for modellen kalles problemløsing for behandling av naturlig språkinformasjon, for eksempel å forutsi ferdigstillelse av en uferdig setning, svare på spørsmål, leseforståelse, danne konklusjoner i naturlig språk og analysere uklarheten i betydningen av ord..

Hvis du er interessert i å vite mer om det, kan du sjekke detaljene til StyleGAN3 I den følgende lenken.